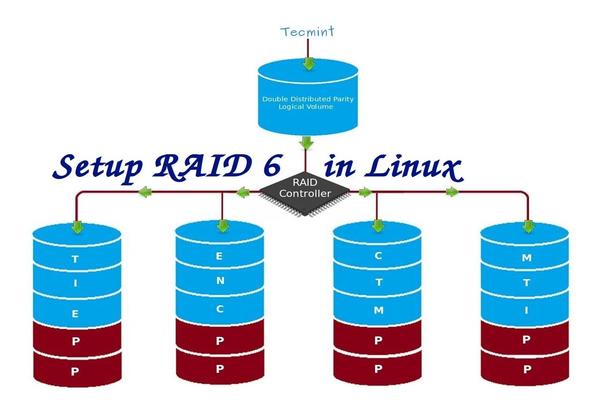

Configuración de RAID nivel 6 (striping con doble paridad distribuida) en Linux - Parte 5

RAID 6 es una versión mejorada de RAID 5, donde tiene dos paridades distribuidas que proporcionan tolerancia a fallas incluso después de que fallan dos unidades. El sistema de misión crítica aún está operativo en caso de fallas de dos discos simultáneos. Es parecido a RAID 5, pero es más robusto porque utiliza un disco más para la paridad.

En nuestro artículo anterior, vimos paridad distribuida en RAID 5, pero en este artículo veremos RAID 6 con doble paridad distribuida. No espere un rendimiento adicional que cualquier otro RAID; de ser así, también tendremos que instalar un controlador RAID dedicado. Aquí, en RAID 6, incluso si perdemos nuestros 2 discos, podemos recuperar los datos reemplazando una unidad de repuesto y construyéndola a partir de la paridad.

Para configurar un RAID 6, se requiere un mínimo de 4 discos o más en un conjunto. RAID 6 tiene varios discos, incluso en algún conjunto puede tener varios discos, mientras lee, leerá desde todas las unidades, por lo que la lectura sería más rápida mientras que la escritura sería deficiente porque tiene que rayar en varios discos.

Ahora, muchos de nosotros llegamos a la conclusión de por qué necesitamos usar RAID 6, cuando no funciona como cualquier otro RAID. Hmm... aquellos que plantean esta pregunta deben saber que, si necesitan una alta tolerancia a fallos, elijan RAID 6. En todos los entornos superiores con alta disponibilidad para la base de datos, utilizan RAID 6 porque la base de datos es la más importante y Debe ser seguro a cualquier costo, también puede ser útil para entornos de transmisión de video.

Pros y contras de RAID 6

- El rendimiento es bueno.

- RAID 6 es caro, ya que requiere que se utilicen dos unidades independientes para las funciones de paridad.

- Perderá capacidad de dos discos por utilizar información de paridad (doble paridad).

- No se pierden datos, incluso después de que fallan dos discos. Podemos reconstruir desde la paridad después de reemplazar el disco fallido.

- La lectura será mejor que RAID 5, porque lee desde varios discos, pero el rendimiento de escritura será muy pobre sin un controlador RAID dedicado.

Requisitos

Se requieren un mínimo de 4 discos para crear un RAID 6. Si desea agregar más discos, puede hacerlo, pero debe tener un controlador raid dedicado. En RAID por software, no obtendremos un mejor rendimiento en RAID 6. Por lo tanto, necesitamos un controlador RAID físico.

A aquellos que son nuevos en la configuración de RAID, les recomendamos que consulten los artículos de RAID a continuación.

- Conceptos básicos de RAID en Linux – Parte 1

- Creación de software RAID 0 (Stripe) en Linux – Parte 2

- Configuración de RAID 1 (duplicación) en Linux – Parte 3

Configuración de mi servidor

Operating System : CentOS 6.5 Final

IP Address : 192.168.0.228

Hostname : rd6.tecmintlocal.com

Disk 1 [20GB] : /dev/sdb

Disk 2 [20GB] : /dev/sdc

Disk 3 [20GB] : /dev/sdd

Disk 4 [20GB] : /dev/sde

Este artículo es una Parte 5 de una serie de 9 tutoriales RAID, aquí veremos cómo podemos crear y configurar Software RAID 6 o Striping con Doble Paridad Distribuida en Sistemas o servidores Linux que utilizan cuatro discos de 20 GB denominados /dev/sdb, /dev/sdc, /dev/sdd y /dev/sde.

Paso 1: Instalar la herramienta mdadm y examinar las unidades

1. Si estás siguiendo nuestros dos últimos artículos sobre Raid (Parte 2 y Parte 3), donde ya hemos mostrado cómo Instale la herramienta 'mdadm'. Si eres nuevo en este artículo, déjame explicarte que 'mdadm' es una herramienta para crear y administrar Raid en sistemas Linux. Instalemos la herramienta usando el siguiente comando según su distribución de Linux.

yum install mdadm [on RedHat systems]

apt-get install mdadm [on Debain systems]

2. Después de instalar la herramienta, ahora es el momento de verificar las cuatro unidades conectadas que usaremos para la creación de raid usando el siguiente comando 'fdisk'.

fdisk -l | grep sd

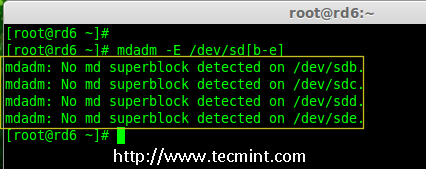

3. Antes de crear unidades RAID, siempre examine nuestras unidades de disco para ver si ya hay algún RAID creado en los discos.

mdadm -E /dev/sd[b-e]

mdadm --examine /dev/sdb /dev/sdc /dev/sdd /dev/sde

Nota: En la imagen de arriba se muestra que no se detecta ningún superbloque o que no se define ningún RAID en cuatro unidades de disco. Es posible que avancemos más para comenzar a crear RAID 6.

Paso 2: Partición de unidades para RAID 6

4. Ahora cree particiones para raid en '/dev/sdb', '/dev/sdc', '/dev/ sdd' y '/dev/sde' con la ayuda del siguiente comando fdisk. Aquí, mostraremos cómo crear una partición en la unidad sdb y luego los mismos pasos a seguir para el resto de las unidades.

Crear partición /dev/sdb

fdisk /dev/sdb

Siga las instrucciones que se muestran a continuación para crear una partición.

- Presione 'n' para crear una nueva partición.

- Luego elija 'P' para Partición primaria.

- Luego elija el número de partición como 1.

- Defina el valor predeterminado simplemente presionando dos veces la tecla Enter.

- Luego presione 'P' para imprimir la partición definida.

- Presione 'L' para enumerar todos los tipos disponibles.

- Escriba 't' para elegir las particiones.

- Elija 'fd' para la incursión automática de Linux y presione Entrar para aplicar.

- Luego use nuevamente 'P' para imprimir los cambios que hemos realizado.

- Utilice 'w' para escribir los cambios.

Crear partición /dev/sdb

fdisk /dev/sdc

Crear partición /dev/sdd

fdisk /dev/sdd

Crear partición /dev/sde

fdisk /dev/sde

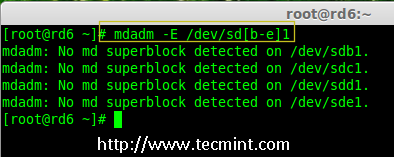

5. Después de crear particiones, siempre es una buena costumbre examinar las unidades en busca de superbloques. Si no existen superbloques, podemos crear una nueva configuración RAID.

mdadm -E /dev/sd[b-e]1

or

mdadm --examine /dev/sdb1 /dev/sdc1 /dev/sdd1 /dev/sde1

Paso 3: creación de dispositivo MD (RAID)

6. Ahora es el momento de crear el dispositivo Raid 'md0' (es decir, /dev/md0) y aplicar el nivel de raid en todas las particiones recién creadas y Confirme la incursión usando los siguientes comandos.

mdadm --create /dev/md0 --level=6 --raid-devices=4 /dev/sdb1 /dev/sdc1 /dev/sdd1 /dev/sde1

cat /proc/mdstat

7. También puedes verificar el proceso actual de raid usando el comando watch como se muestra en la siguiente captura de pantalla.

watch -n1 cat /proc/mdstat

8. Verifique los dispositivos raid usando el siguiente comando.

mdadm -E /dev/sd[b-e]1

Nota:: El comando anterior mostrará la información de los cuatro discos, lo cual es bastante largo, por lo que no es posible publicar el resultado o la captura de pantalla aquí.

9. A continuación, verifique la matriz RAID para confirmar que se inició la resincronización.

mdadm --detail /dev/md0

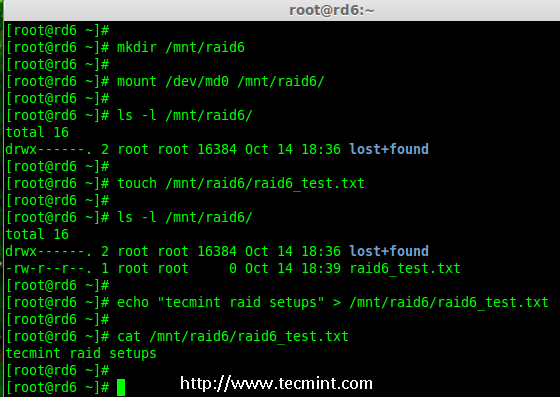

Paso 4: Crear un sistema de archivos en un dispositivo Raid

10. Cree un sistema de archivos usando ext4 para '/dev/md0' y móntelo en /mnt/raid6. Aquí hemos usado ext4, pero puede usar cualquier tipo de sistema de archivos según su elección.

mkfs.ext4 /dev/md0

11. Monte el sistema de archivos creado en /mnt/raid6 y verifique los archivos en el punto de montaje, podemos ver el directorio perdido+encontrado.

mkdir /mnt/raid6

mount /dev/md0 /mnt/raid6/

ls -l /mnt/raid6/

12. Cree algunos archivos en el punto de montaje y agregue texto en cualquiera de los archivos para verificar el contenido.

touch /mnt/raid6/raid6_test.txt

ls -l /mnt/raid6/

echo "tecmint raid setups" > /mnt/raid6/raid6_test.txt

cat /mnt/raid6/raid6_test.txt

13. Agregue una entrada en /etc/fstab para montar automáticamente el dispositivo al iniciar el sistema y agregue la siguiente entrada; el punto de montaje puede diferir según su entorno.

vim /etc/fstab

/dev/md0 /mnt/raid6 ext4 defaults 0 0

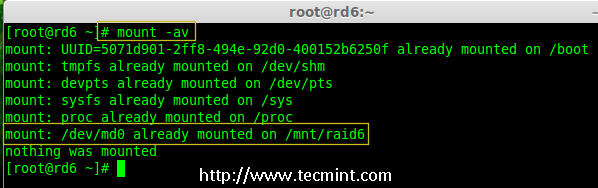

14. A continuación, ejecute el comando 'mount -a' para verificar si hay algún error en la entrada fstab.

mount -av

Paso 5: guarde la configuración RAID 6

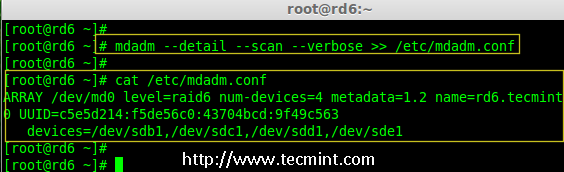

15. Tenga en cuenta que, de forma predeterminada, RAID no tiene un archivo de configuración. Tenemos que guardarlo manualmente usando el siguiente comando y luego verificar el estado del dispositivo '/dev/md0'.

mdadm --detail --scan --verbose >> /etc/mdadm.conf

mdadm --detail /dev/md0

Paso 6: Agregar unidades de repuesto

16. Ahora tiene 4 discos y hay dos informaciones de paridad disponibles. En algunos casos, si alguno de los discos falla, podemos obtener los datos, porque hay doble paridad en RAID 6.

Puede ser que si el segundo disco falla, podamos agregar uno nuevo antes de perder el tercer disco. Es posible agregar una unidad de repuesto al crear nuestro conjunto RAID, pero no he definido la unidad de repuesto al crear nuestro conjunto de RAID. Pero podemos agregar una unidad de repuesto después de cualquier falla de la unidad o mientras creamos el conjunto RAID. Ahora que ya hemos creado el conjunto RAID, ahora permítanme agregar una unidad de repuesto para demostración.

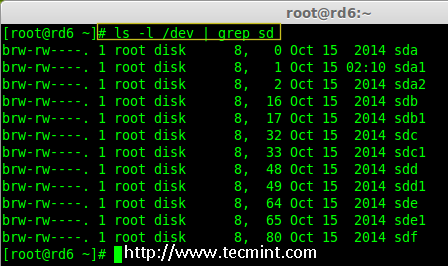

Para fines de demostración, conecté en caliente un nuevo disco HDD (es decir, /dev/sdf), verifiquemos el disco adjunto.

ls -l /dev/ | grep sd

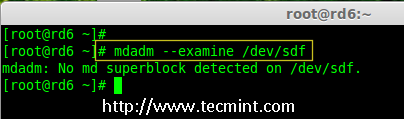

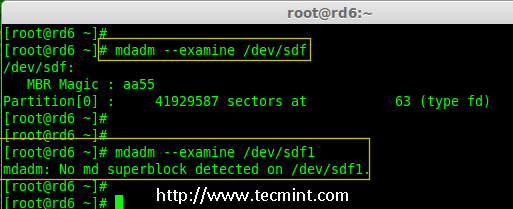

17. Ahora confirme nuevamente que el nuevo disco adjunto para cualquier raid ya esté configurado o no use el mismo comando mdadm.

mdadm --examine /dev/sdf

Nota: Como de costumbre, como hemos creado particiones para cuatro discos anteriormente, de manera similar debemos crear una nueva partición en el nuevo disco conectado usando fdisk comando .

fdisk /dev/sdf

18. Nuevamente, después de crear una nueva partición en /dev/sdf, confirme la incursión en la partición, incluya la unidad de repuesto en /dev/md0 raid dispositivo y verificar el dispositivo agregado.

mdadm --examine /dev/sdf

mdadm --examine /dev/sdf1

mdadm --add /dev/md0 /dev/sdf1

mdadm --detail /dev/md0

Paso 7: Verifique la tolerancia a fallas de Raid 6

19. Ahora, verifiquemos si la unidad de repuesto funciona automáticamente, si alguno de los discos falla en nuestro Array. Para realizar pruebas, personalmente marqué que una de las unidades falló.

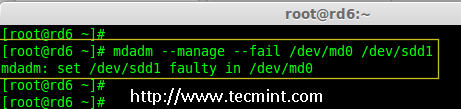

Aquí marcaremos /dev/sdd1 como unidad fallida.

mdadm --manage --fail /dev/md0 /dev/sdd1

20. Déjame obtener los detalles del RAID configurado ahora y verificar si nuestro repuesto comenzó a sincronizarse.

mdadm --detail /dev/md0

¡Hurra! Aquí podemos ver que el repuesto se activó y comenzó el proceso de reconstrucción. En la parte inferior podemos ver la unidad defectuosa /dev/sdd1 listada como defectuosa. Podemos monitorear el proceso de compilación usando el siguiente comando.

cat /proc/mdstat

Conclusión:

Aquí hemos visto cómo configurar RAID 6 usando cuatro discos. Este nivel RAID es una de las configuraciones costosas con alta redundancia. Veremos cómo configurar un RAID 10 anidado y mucho más en los próximos artículos. Hasta entonces, mantente conectado con TECMINT.