LFCS #6: Cómo ensamblar particiones como dispositivos RAID en Linux

La Linux Foundation lanzó la certificación LFCS (Linux Foundation Certified Sysadmin), una brillante oportunidad para que los administradores de sistemas de todo el mundo demuestren, a través de un examen basado en el desempeño, que son capaces de realizar soporte operativo general en sistemas Linux: soporte del sistema, diagnóstico y monitoreo de primer nivel, además de escalamiento de problemas, cuando sea necesario, a otros equipos de soporte.

La serie se titulará Preparación para la LFCS (Administrador de sistemas certificado por la Fundación Linux) Partes 1 a la 33 y cubrirá las siguientes temas:

- Part 1

Cómo utilizar el comando 'Sed' para manipular archivos en Linux

- Part 2

Cómo instalar y usar Vi/Vim en Linux

- Part 3

Cómo comprimir archivos y directorios y buscar archivos en Linux

- Part 4

-

Cómo particionar dispositivos de almacenamiento en Linux

- Part 5

Cómo montar sistemas de archivos (Samba y NFS) en Linux

- Part 6

Cómo ensamblar particiones como dispositivos RAID y crear copias de seguridad del sistema

- Part 7

Gestión de procesos y servicios de inicio del sistema (SysVinit, Systemd y Upstart

- Part 8

Cómo administrar usuarios y grupos, permisos de archivos y acceso a Sudo

- Part 9

Gestión de paquetes de Linux con Yum, RPM, Apt, Dpkg, Aptitude y Zypper

- Part 10

Aprendizaje de secuencias de comandos de Shell básicas y solución de problemas del sistema de archivos

- Part 11

Cómo administrar y crear LVM usando los comandos vgcreate, lvcreate y lvextend

- Part 12

Cómo explorar Linux con herramientas y documentación de ayuda instaladas

- Part 13

Cómo configurar y solucionar problemas de Grand Unified Bootloader (GRUB)

- Part 14

-

Supervise el uso de recursos de los procesos de Linux y establezca límites de proceso por usuario

- Part 15

Cómo configurar o modificar los parámetros de tiempo de ejecución del kernel en sistemas Linux

- Part 16

Implementación de control de acceso obligatorio con SELinux o AppArmor en Linux

- Part 17

Cómo configurar listas de control de acceso (ACL) y cuotas de disco para usuarios y grupos

- Part 18

Instalación de servicios de red y configuración del inicio automático al arrancar

- Part 19

Una guía definitiva para configurar un servidor FTP para permitir inicios de sesión anónimos

- Part 20

Configure un servidor DNS de almacenamiento en caché recursivo básico y configure zonas para el dominio

- Part 21

Cómo instalar, proteger y ajustar el rendimiento del servidor de base de datos MariaDB

- Part 22

Cómo instalar y configurar el servidor NFS para compartir sistemas de archivos

- Part 23

Cómo configurar Apache con alojamiento virtual basado en nombres con certificado SSL

- Part 24

-

Cómo configurar un firewall de Iptables para permitir el acceso remoto a servicios en Linux

- Part 25

Cómo convertir un Linux en un enrutador para manejar el tráfico de forma estática y dinámica

- Part 26

Cómo configurar sistemas de archivos cifrados e intercambiarlos utilizando la herramienta Cryptsetup

- Part 27

Cómo monitorear el uso del sistema, las interrupciones y solucionar problemas de servidores Linux

- Part 28

Cómo configurar un repositorio de red para instalar o actualizar paquetes

- Part 29

Cómo auditar el rendimiento, la seguridad y la solución de problemas de la red

- Part 30

Cómo instalar y administrar máquinas virtuales y contenedores

- Part 31

Aprenda los conceptos básicos de Git para gestionar proyectos de forma eficiente

- Part 32

Una guía para principiantes para configurar direcciones IPv4 e IPv6 en Linux

- Part 33

Una guía para principiantes para crear enlaces y puentes de red en Ubuntu

Esta publicación es la Parte 6 de una serie de 33 tutoriales. Aquí, en esta parte, explicaremos cómo ensamblar particiones como dispositivos RAID y crear y administrar copias de seguridad del sistema, que son requerido para el examen de certificación LFCS.

Entendiendo RAID en Linux

La tecnología conocida como Matriz Redundante de Discos Independientes (RAID) es una solución de almacenamiento que combina múltiples discos duros en una sola unidad lógica para proporcionar redundancia de datos y/o mejorar el rendimiento. en operaciones de lectura/escritura en disco.

Sin embargo, la tolerancia a fallas real y el rendimiento de E/S del disco dependen de cómo se configuran los discos duros para formar la matriz de discos. Dependiendo de los dispositivos disponibles y las necesidades de rendimiento/tolerancia a fallos, se definen diferentes niveles de RAID.

Puede consultar el siguiente artículo de la serie RAID para obtener una explicación más detallada de cada nivel de RAID.

Instalar mdadm en Linux

Nuestra herramienta preferida para crear, ensamblar, administrar y monitorear nuestros RAID de software se llama mdadm (abreviatura de administrador de múltiples discos).

sudo apt install mdadm [On Debian, Ubuntu and Mint]

sudo yum install mdadm [On RHEL/CentOS/Fedora and Rocky/AlmaLinux]

sudo zypper install mdadm [On OpenSUSE]

Montaje de particiones como dispositivos RAID

El proceso de ensamblar particiones existentes como dispositivos RAID consta de los siguientes pasos.

1. Cree una nueva matriz usando mdadm

Si una de las particiones ha sido formateada anteriormente o ha sido parte de otra matriz RAID anteriormente, se le pedirá que confirme la creación de la nueva matriz.

Suponiendo que haya tomado las precauciones necesarias para evitar la pérdida de datos importantes que puedan haber residido en ellos, puede escribir y con seguridad y presionar Entrar.

mdadm --create --verbose /dev/md0 --level=stripe --raid-devices=2 /dev/sdb1 /dev/sdc1

2. Verifique el estado de creación de la matriz

Para verificar el estado de creación de la matriz, utilizará los siguientes comandos, independientemente del tipo de RAID. Estos son tan válidos como cuando estamos creando un RAID0 (como se muestra arriba), o cuando estás en el proceso de configurar un RAID5, como se muestra en la imagen. abajo.

cat /proc/mdstat

or

mdadm --detail /dev/md0 [More detailed summary]

3. Formatear el dispositivo RAID

Formatee el dispositivo con un sistema de archivos según sus necesidades/requisitos, como se explica en la Parte 4 de esta serie.

4. Supervisar el servicio de matriz RAID

Indique al servicio de monitoreo que "vigile" la matriz. Agregue la salida de mdadm --detail --scan a /etc/mdadm/mdadm.conf (Debian y derivados) o /etc/mdadm.conf (CentOS/openSUSE), así.

mdadm --detail --scan

mdadm --assemble --scan [Assemble the array]

Para asegurarse de que el servicio se inicie al iniciar el sistema, ejecute los siguientes comandos como root.

systemctl start mdmonitor

systemctl enable mdmonitor

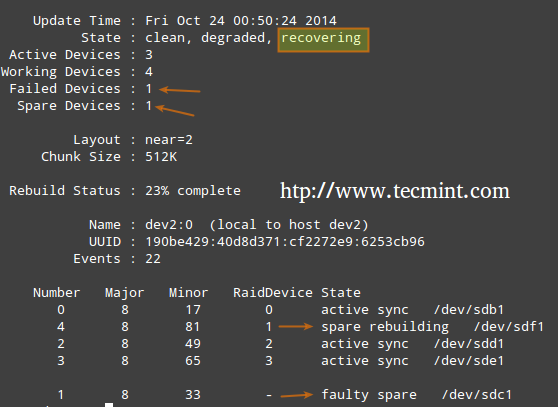

5. Verifique la falla del disco RAID

En los niveles RAID que admiten redundancia, reemplace las unidades defectuosas cuando sea necesario. Cuando un dispositivo en la matriz de discos falla, se inicia automáticamente una reconstrucción solo si se agregó un dispositivo de repuesto cuando creamos la matriz por primera vez.

De lo contrario, debemos conectar manualmente una unidad física adicional a nuestro sistema y ejecutarla.

mdadm /dev/md0 --add /dev/sdX1

Donde /dev/md0 es la matriz que experimentó el problema y /dev/sdX1 es el nuevo dispositivo.

6. Desmontar una matriz funcional

Es posible que deba hacer esto si necesita crear una nueva matriz utilizando los dispositivos (Paso opcional).

mdadm --stop /dev/md0 # Stop the array

mdadm --remove /dev/md0 # Remove the RAID device

mdadm --zero-superblock /dev/sdX1 # Overwrite the existing md superblock with zeroes

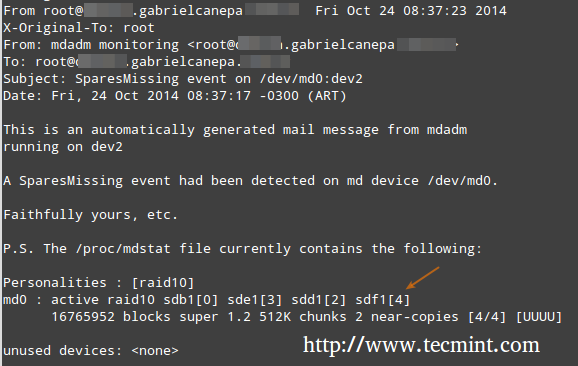

7. Cree alertas por correo

Puede configurar una dirección de correo electrónico válida o una cuenta del sistema para enviar alertas (asegúrese de tener esta línea en mdadm.conf). – (Paso Opcional)

MAILADDR root

En este caso, todas las alertas que recopile el demonio de monitoreo RAID se enviarán al buzón de correo de la cuenta raíz local. Una de esas alertas se parece a la siguiente.

Nota: este evento está relacionado con el ejemplo del PASO 5, donde un dispositivo se marcó como defectuoso y el dispositivo de repuesto se incorporó automáticamente la matriz por mdadm. Por lo tanto, “se nos acabaron ” los dispositivos de repuesto en buen estado y recibimos la alerta.

Comprensión de los niveles RAID en Linux

A continuación se ofrece una breve descripción general de los niveles RAID comunes:

RAID 0

El tamaño total de la matriz es n veces el tamaño de la partición más pequeña, donde n es el número de discos independientes en la matriz (necesitará al menos dos unidades). Ejecute el siguiente comando para ensamblar una matriz RAID 0 usando las particiones /dev/sdb1 y /dev/sdc1.

mdadm --create --verbose /dev/md0 --level=stripe --raid-devices=2 /dev/sdb1 /dev/sdc1

Usos comunes: configuraciones que admiten aplicaciones en tiempo real donde el rendimiento es más importante que la tolerancia a fallos.

RAID 1 (también conocido como duplicación)

El tamaño total de la matriz es igual al tamaño de la partición más pequeña (necesitará al menos dos unidades). Ejecute el siguiente comando para ensamblar una matriz RAID 1 usando las particiones /dev/sdb1 y /dev/sdc1.

mdadm --create --verbose /dev/md0 --level=1 --raid-devices=2 /dev/sdb1 /dev/sdc1

Usos comunes: Instalación del sistema operativo o subdirectorios importantes, como /home.

RAID 5 (también conocido como unidades con paridad)

El tamaño total de la matriz será (n – 1) veces el tamaño de la partición más pequeña. El espacio “perdido” en (n-1) se utiliza para el cálculo de paridad (redundancia) (necesitará al menos tres unidades).

Tenga en cuenta que puede especificar un dispositivo de repuesto (/dev/sde1 en este caso) para reemplazar una pieza defectuosa cuando ocurre un problema. Ejecute el siguiente comando para ensamblar una matriz RAID 5 usando las particiones /dev/sdb1, /dev/sdc1, /dev/sdd1 y /dev/sde1 como repuesto.

mdadm --create --verbose /dev/md0 --level=5 --raid-devices=3 /dev/sdb1 /dev/sdc1 /dev/sdd1 --spare-devices=1 /dev/sde1

Usos comunes: Servidores web y de archivos.

RAID 6 (también conocido como unidades con doble paridad)

El tamaño total de la matriz será (n*s)-2*s, donde n es el número de discos independientes en la matriz y s. es el tamaño del disco más pequeño. Tenga en cuenta que puede especificar un dispositivo de repuesto (/dev/sdf1 en este caso) para reemplazar una pieza defectuosa cuando ocurre un problema.

Ejecute el siguiente comando para ensamblar una matriz RAID 6 usando las particiones /dev/sdb1, /dev/sdc1, /dev/sdd1 , /dev/sde1 y /dev/sdf1 como repuesto.

mdadm --create --verbose /dev/md0 --level=6 --raid-devices=4 /dev/sdb1 /dev/sdc1 /dev/sdd1 /dev/sde --spare-devices=1 /dev/sdf1

Usos comunes: Servidores de archivos y copias de seguridad con gran capacidad y requisitos de alta disponibilidad.

RAID 1+0 (también conocido como Stripe of Mirrors)

El tamaño total de la matriz se calcula según las fórmulas para RAID 0 y RAID 1 ya que RAID 1+0 es una combinación de ambos. Primero, calcula el tamaño de cada espejo y luego el tamaño de la franja.

Tenga en cuenta que puede especificar un dispositivo de repuesto (/dev/sdf1 en este caso) para reemplazar una pieza defectuosa cuando ocurre un problema. Ejecute el siguiente comando para ensamblar una matriz RAID 1+0 usando las particiones /dev/sdb1, /dev/sdc1, /dev /sdd1, /dev/sde1 y /dev/sdf1 como repuesto.

mdadm --create --verbose /dev/md0 --level=10 --raid-devices=4 /dev/sd[b-e]1 --spare-devices=1 /dev/sdf1Usos comunes: servidores de aplicaciones y bases de datos que requieren operaciones de E/S rápidas.

Creación y gestión de copias de seguridad del sistema en Linux

Nunca está de más recordar que RAID con todas sus ventajas ¡NO ES UN REEMPLAZO DE LAS COPIAS DE SEGURIDAD! Escríbalo 1000 veces en la pizarra si es necesario, pero asegúrese de conservarlo. idea en mente en todo momento.

Antes de comenzar, debemos tener en cuenta que no existe una solución única para todos para las copias de seguridad del sistema, pero aquí hay algunas cosas que debe tener en cuenta al planificar una estrategia de copia de seguridad.

- ¿Para qué utilizas tu sistema? (¿Escritorio o servidor? Si se aplica el último caso, ¿cuáles son los servicios más críticos, cuya configuración sería realmente difícil perder?)

- ¿Con qué frecuencia necesita realizar copias de seguridad de su sistema?

- ¿Cuáles son los datos (por ejemplo, archivos/directorios/volcados de bases de datos) que desea respaldar? También es posible que desees considerar si realmente necesitas hacer una copia de seguridad de archivos grandes (como archivos de audio o video).

- ¿Dónde (es decir, lugar físico y medios) se almacenarán esas copias de seguridad?

1. Copia de seguridad de unidades mediante el comando dd

Haga una copia de seguridad de unidades enteras con el comando dd. Puede realizar una copia de seguridad de un disco duro completo o de una partición creando una imagen exacta en cualquier momento. Tenga en cuenta que esto funciona mejor cuando el dispositivo está fuera de línea, lo que significa que no está montado y no hay procesos que accedan a él para operaciones de E/S.

La desventaja de este método de copia de seguridad es que la imagen tendrá el mismo tamaño que el disco o la partición, incluso cuando los datos reales ocupen un pequeño porcentaje del mismo.

Por ejemplo, si desea crear una imagen de una partición de 20 GB que sólo está 10% llena, el archivo de imagen seguirá teniendo 20 GB en tamaño. En otras palabras, no sólo se realiza una copia de seguridad de los datos reales, sino de toda la partición. Puede considerar utilizar este método si necesita copias de seguridad exactas de sus dispositivos.

Crear una imagen de partición

dd if=/dev/sda of=/system_images/sda.img

OR

--------------------- Alternatively, you can compress the image file ---------------------

dd if=/dev/sda | gzip -c > /system_images/sda.img.gz

Restaurar una imagen de partición

dd if=/system_images/sda.img of=/dev/sda

OR

gzip -dc /system_images/sda.img.gz | dd of=/dev/sda

2. Copia de seguridad de archivos usando el comando tar

Haga una copia de seguridad de ciertos archivos de los directorios / con el comando tar, ya tratado en la Parte 3 de esta serie. Puede considerar utilizar este método si necesita conservar copias de archivos y directorios específicos (archivos de configuración, directorios de inicio de los usuarios, etc.).

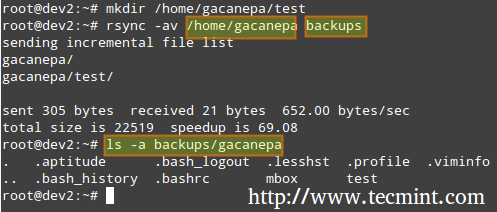

2. Copia de seguridad y sincronización de archivos mediante el comando rsync

Sincronice archivos con el comando rsync, que es una herramienta versátil de copia de archivos remota (y local). Si necesita hacer una copia de seguridad y sincronizar sus archivos hacia/desde unidades de red, rsync es una opción.

Ya sea que esté sincronizando dos directorios locales o directorios remotos locales < --- >>code> montados en el sistema de archivos local, la sintaxis básica es la misma.

Sincronización de dos directorios locales

rsync -av source_directory destination directory

Donde, -a se repite en subdirectorios (si existen), conserva enlaces simbólicos, marcas de tiempo, permisos y propietario/grupo original y -v detallado.

Además, si desea aumentar la seguridad de la transferencia de datos por cable, puede utilizar ssh en lugar de rsync.

Sincronización de directorios locales → remotos a través de SSH

rsync -avzhe ssh backups root@remote_host:/remote_directory/

Este ejemplo sincronizará el directorio de respaldo en el host local con el contenido de /root/remote_directory en el host remoto.

Donde la opción -h muestra los tamaños de archivos en formato legible por humanos y el indicador -e se usa para indicar una conexión SSH.

Sincronización de directorios remotos → locales a través de SSH

En este caso, cambie los directorios de origen y destino del ejemplo anterior.

rsync -avzhe ssh root@remote_host:/remote_directory/ backups

Tenga en cuenta que estos son sólo 3 ejemplos (los casos más frecuentes con los que probablemente se encontrará) del uso de rsync. Para obtener más ejemplos y usos de los comandos rsync, puede encontrarlos en el siguiente artículo.

Resumen

Como administrador de sistemas, debe asegurarse de que sus sistemas funcionen lo mejor posible. Si está bien preparado y si la integridad de sus datos está bien respaldada por tecnología de almacenamiento como RAID y copias de seguridad periódicas del sistema, estará a salvo.

El libro electrónico LFCS ya está disponible para su compra. ¡Solicite su copia hoy y comience su viaje para convertirse en un administrador certificado de sistemas Linux!

| Product Name | Price | Buy |

|---|---|---|

| The Linux Foundation’s LFCS Certification Preparation Guide | $19.99 | [Buy Now] |

Por último, pero no menos importante, considere comprar su vale de examen utilizando los siguientes enlaces para ganarnos una pequeña comisión, que nos ayudará a mantener este libro actualizado.

Si tiene preguntas, comentarios o más ideas sobre cómo se puede mejorar este artículo, no dude en expresarlo a continuación. Además, considere compartir esta serie a través de sus perfiles de redes sociales.