Mejores prácticas para implementar Hadoop Server en CentOS/RHEL 7 - Parte 1

En esta serie de artículos, cubriremos todo el desarrollo de Cloudera Hadoop Cluster Building con las mejores prácticas recomendadas por proveedores e industriales.

La instalación del SO y los requisitos previos a nivel del OS son los primeros pasos para crear un clúster de Hadoop. Hadoop puede ejecutarse en varios tipos de plataforma Linux: CentOS, RedHat, Ubuntu, Debian<, SUSE, etc. En producción en tiempo real, la mayoría de los Hadoop Clusters se construyen sobre RHEL/CentOS, nosotros Utilizará CentOS 7 para la demostración en esta serie de tutoriales.

En una organización, la instalación del sistema operativo se puede realizar mediante kickstart. Si se trata de un clúster de 3 a 4 nodos, la instalación manual es posible, pero si construimos un clúster grande con más de 10 nodos, resulta tedioso instalar el sistema operativo uno por uno. En este escenario, el método Kickstart entra en escena, podemos continuar con la instalación masiva usando kickstart.

Lograr un buen rendimiento en un entorno Hadoop depende del aprovisionamiento del hardware y software correctos. Por lo tanto, construir un clúster de Hadoop de producción implica mucha consideración con respecto al hardware y al software.

En este artículo, analizaremos varios puntos de referencia sobre la instalación del sistema operativo y algunas prácticas recomendadas para implementar Cloudera Hadoop Cluster Server en CentOS/RHEL 7.

Consideración importante y mejores prácticas para implementar Hadoop Server

Las siguientes son las mejores prácticas para configurar la implementación de Cloudera Hadoop Cluster Server en CentOS/RHEL 7.

- Los servidores Hadoop no requieren servidores estándar empresariales para construir un clúster, sino hardware básico.

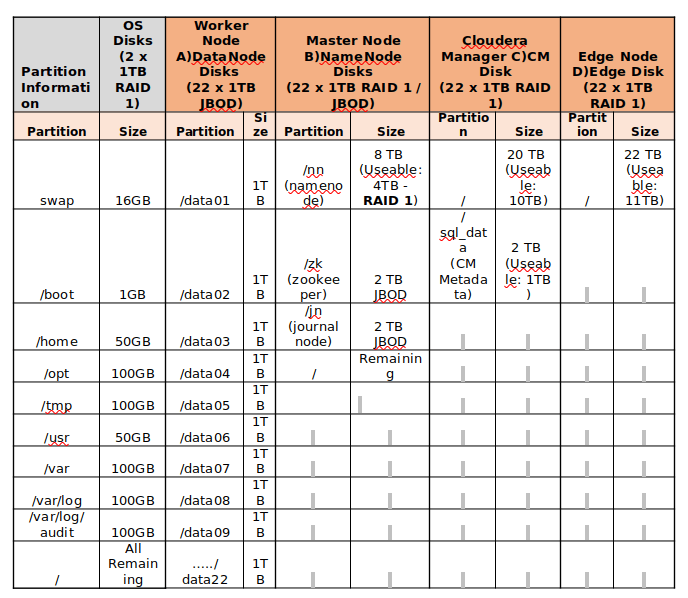

- En el clúster de producción, se recomienda tener de 8 a 12 discos de datos. Según la naturaleza de la carga de trabajo, debemos decidir al respecto. Si el clúster es para aplicaciones de computación intensiva, la mejor práctica es tener de 4 a 6 unidades para evitar problemas de E/S.

- Las unidades de datos deben particionarse individualmente, por ejemplo, desde /data01 hasta /data10.

- No se recomienda la configuración RAID para nodos trabajadores, porque el propio Hadoop proporciona tolerancia a fallos en los datos al replicar los bloques en 3 de forma predeterminada. Por lo tanto, JBOD es mejor para los nodos trabajadores.

- Para servidores maestros, RAID 1 es la mejor práctica.

- El sistema de archivos predeterminado en CentOS/RHEL 7.x es XFS. Hadoop admite XFS, ext3 y ext4. El sistema de archivos recomendado es ext3, ya que se ha probado su buen rendimiento.

- Todos los servidores deben tener la misma versión del sistema operativo, al menos la misma versión menor.

- Lo mejor es tener hardware homogéneo (todos los nodos trabajadores deben tener las mismas características de hardware (RAM, espacio en disco y núcleo, etc.).

- Según la carga de trabajo del clúster (carga de trabajo equilibrada, computación intensiva, E/S intensiva) y el tamaño, la planificación de recursos (RAM, CPU) por servidor será diferente.

Encuentre el siguiente ejemplo de partición de disco de servidores de almacenamiento de 24 TB.

Instalación de CentOS 7 para la implementación del servidor Hadoop

Cosas que necesita saber antes de instalar el servidor CentOS 7 para Hadoop Server.

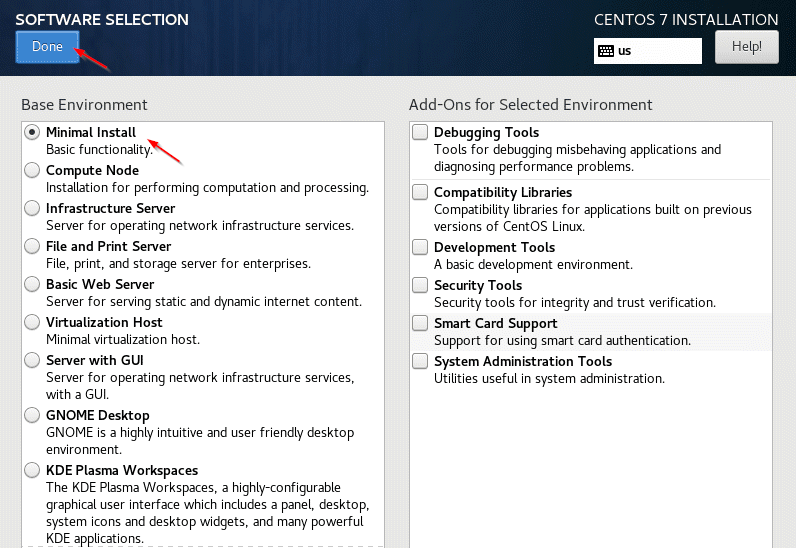

- Una instalación mínima es suficiente para los servidores Hadoop (nodos trabajadores), en algunos casos, la GUI se puede instalar solo para servidores maestros o servidores de administración donde podemos usar navegadores para las UI web de Herramientas administrativas.

- La configuración de redes, nombres de host y otras configuraciones relacionadas con el sistema operativo se puede realizar después de la instalación del sistema operativo.

- En tiempo real, los proveedores de servidores tendrán su propia consola para interactuar y administrar los servidores, por ejemplo: los servidores Dell tienen iDRAC, que es un dispositivo integrado con servidores. Usando esa interfaz iDRAC podemos instalar el sistema operativo teniendo una imagen del sistema operativo en nuestro sistema local.

En este artículo, hemos instalado el sistema operativo (CentOS 7) en la máquina virtual VMware. Aquí no tendremos varios discos para realizar particiones. CentOS es similar a RHEL (misma funcionalidad), por lo que veremos los pasos para instalar CentOS.

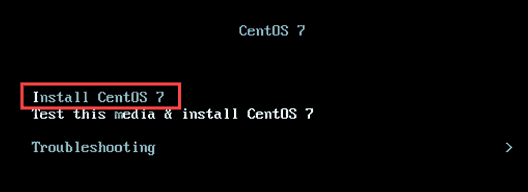

1. Comience descargando la imagen ISO de CentOS 7.x en su sistema Windows local y selecciónela mientras inicia la máquina virtual. Seleccione 'Instalar CentOS 7' como se muestra.

2. Seleccione el Idioma, el valor predeterminado será inglés y haga clic en continuar.

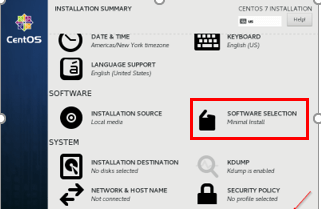

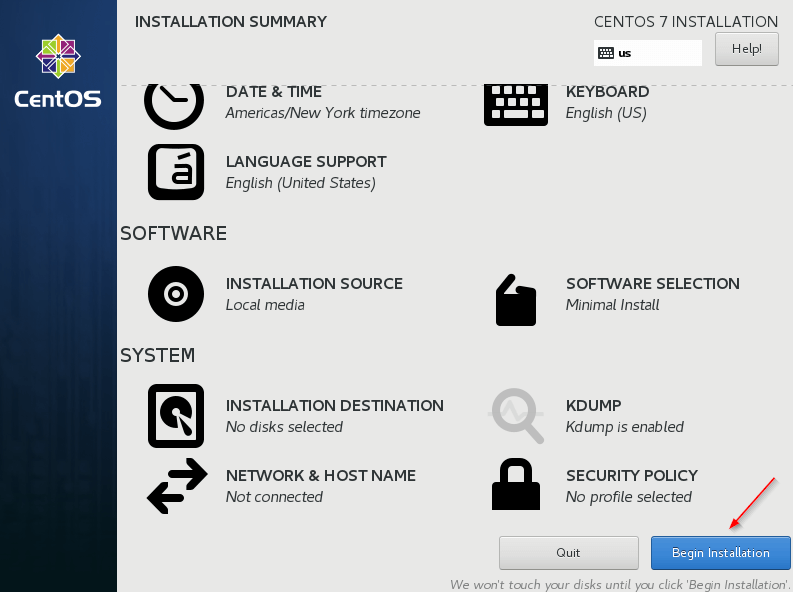

3. Selección de software: seleccione 'Instalación mínima' y haga clic en 'Listo'.

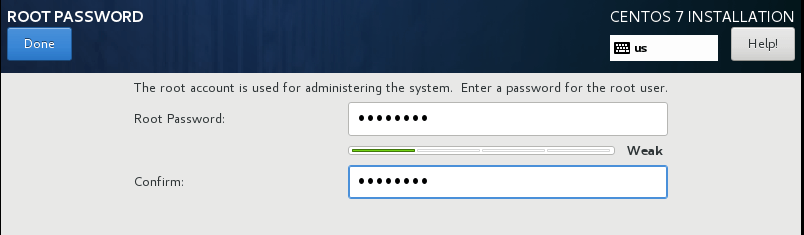

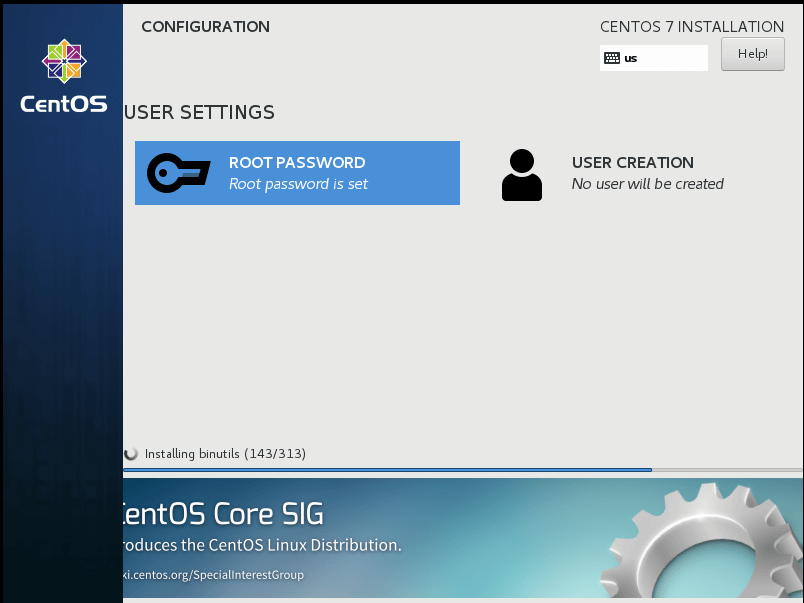

4. Establezca la contraseña de root tal como nos indicará que la establezcamos.

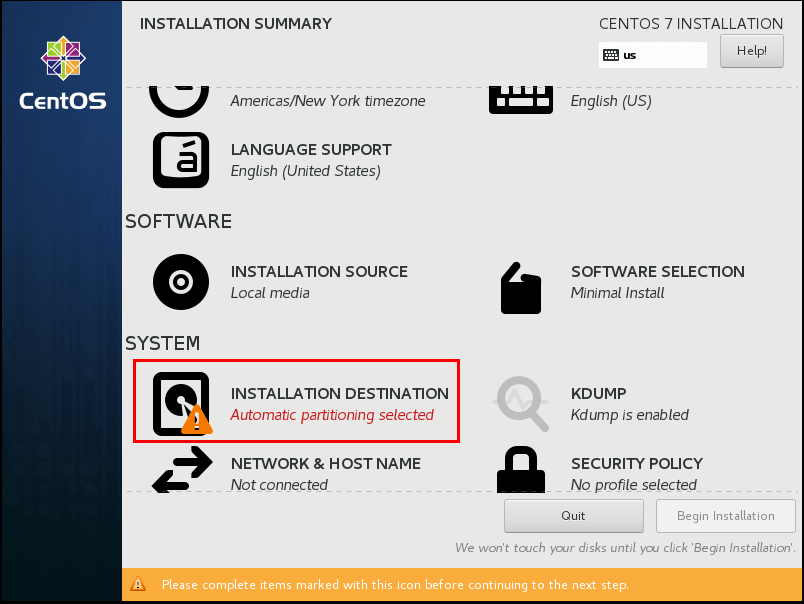

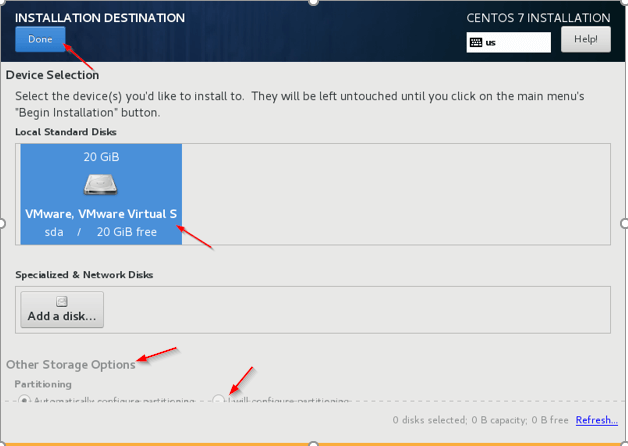

5. Destino de instalación: este es el paso importante que debe tener cuidado. Necesitamos seleccionar el disco donde se debe instalar el sistema operativo, se debe seleccionar el disco dedicado para el sistema operativo. Haga clic en 'Destino de instalación' y seleccione el Disco, en tiempo real habrá varios discos allí, debemos seleccionar, preferiblemente 'sda'.

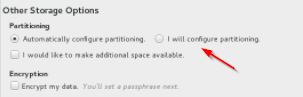

6. Otras opciones de almacenamiento: elija la segunda opción (configuraré la partición) para configurar la partición relacionada con el sistema operativo, como /var, / var/log, /home, /tmp, /opt, /swap.

7. Una vez hecho esto, comience la instalación.

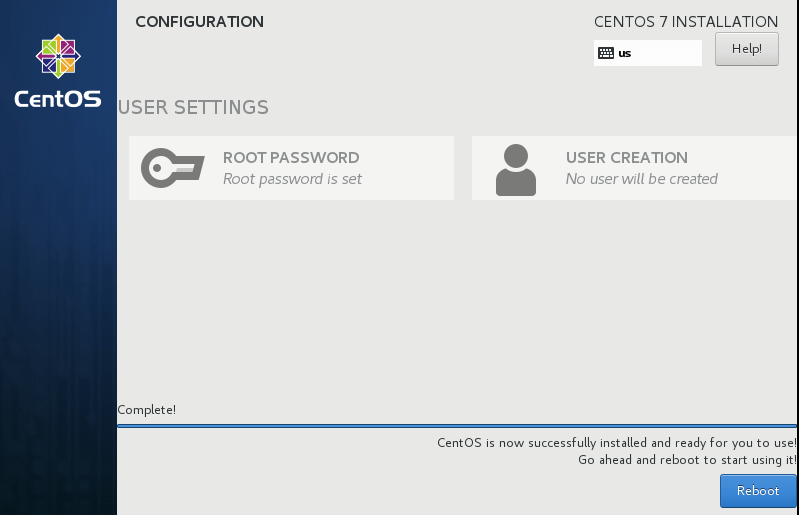

8. Una vez completada la instalación, reinicie el servidor.

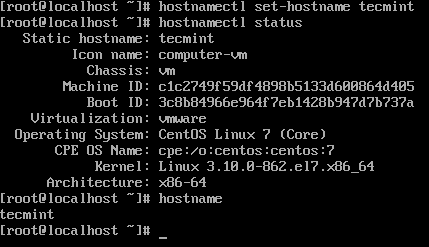

9. Inicie sesión en el servidor y configure el nombre de host.

hostnamectl status

hostnamectl set-hostname tecmint

hostnamectl status

Resumen

En este artículo, analizamos los pasos de instalación del sistema operativo y las mejores prácticas para la partición del sistema de archivos. Todas estas son pautas generales; según la naturaleza de la carga de trabajo, es posible que debamos concentrarnos en más matices para lograr el mejor rendimiento del clúster. La planificación de clústeres es un arte para el administrador de Hadoop. En el próximo artículo profundizaremos en los requisitos previos a nivel del sistema operativo y el refuerzo de seguridad.