Cómo configurar Xorg como sesión predeterminada de GNOME en Fedora

Wayland es un protocolo de visualización seguro, así como una biblioteca que implementa el protocolo, que permite la comunicación entre su hardware de video (el servidor) y los clientes (todas y cada una de las aplicaciones de su sistema). Wayland es el servidor de visualización predeterminado de GNOME.

Si nota que algunas de sus aplicaciones no funcionan como se esperaba en Wayland, puede cambiar a GNOME en X11 como se muestra en este artículo.

Para ejecutar GNOME en X11 en Fedora Linux, hay dos formas de hacerlo. La primera es eligiendo la opción Gnome en xorg en el selector de sesión en la pantalla de inicio de sesión y la segunda forma es editando manualmente la visualización de GNOME. configuración del administrador (GDM) como se muestra a continuación.

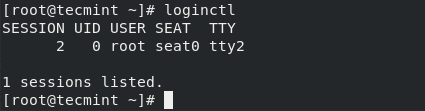

Primero, determine el número de sesión y otros detalles ejecutando el siguiente comando loginctl.

loginctl

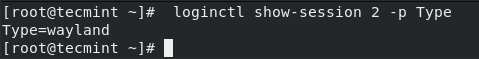

A continuación, averigüe el tipo de sesión que se está ejecutando utilizando el siguiente comando (reemplace 2 con su número de sesión real).

loginctl show-session 2 -p Type

Ahora abra el archivo de configuración GDM /etc/gdm/custom.conf usando su editor de texto favorito.

vi /etc/gdm/custom.conf

Luego, descomente la línea siguiente para forzar que la pantalla de inicio de sesión use el administrador de pantalla Xorg.

WaylandEnable=false

Y agregue también la siguiente línea a la sección [daemon].

DefaultSession=gnome-xorg.desktop

Todo el archivo de configuración de GDM ahora debería verse así.

GDM configuration storage

[daemon]

WaylandEnable=false

DefaultSession=gnome-xorg.desktop

[security]

[xdmcp]

[chooser]

[debug]

#Enable=true

Guarde los cambios en el archivo y reinicie su sistema para comenzar a usar xorg como administrador de sesiones de GNOME predeterminado.

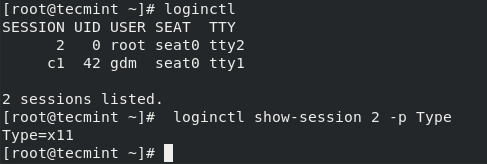

Después de reiniciar el sistema, verifique nuevamente su número de sesión y escriba ejecutando los siguientes comandos, debería mostrar Xorg.

loginctl # get session number from command output

loginctl show-session 2 -p Type

¡Eso es todo! En este artículo, hemos explicado cómo configurar Xorg como la sesión de GNOME predeterminada en Fedora Linux. No olvide comunicarse con nosotros a través del formulario de comentarios a continuación, si tiene alguna pregunta o comentario.